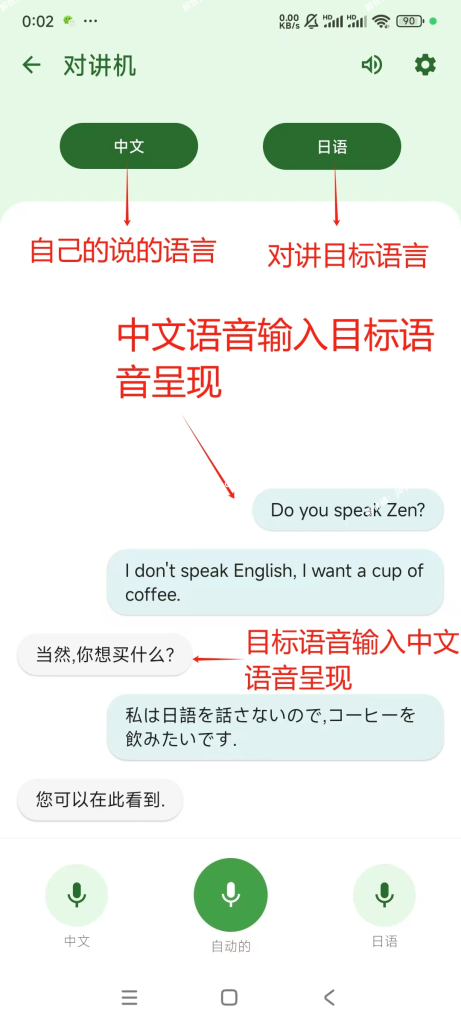

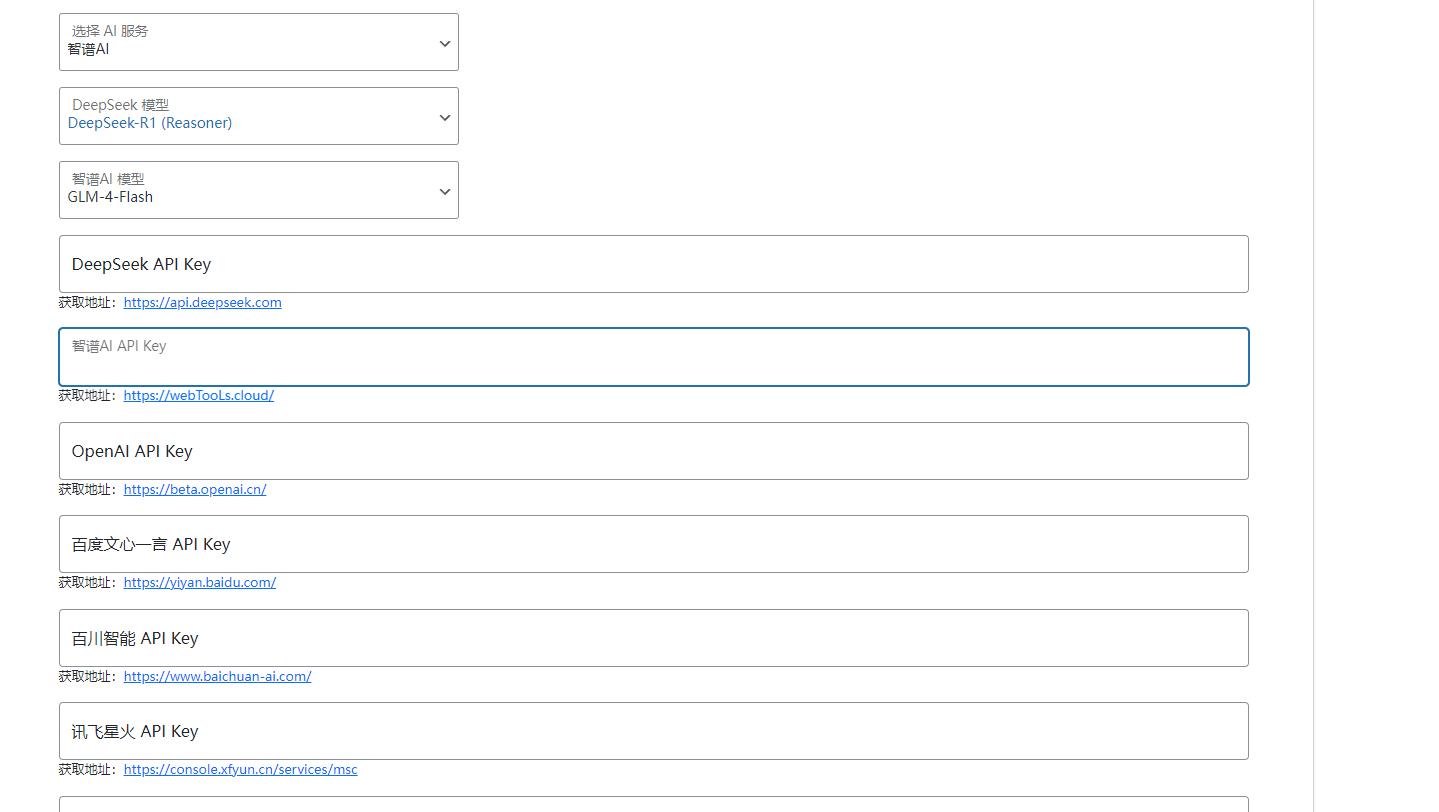

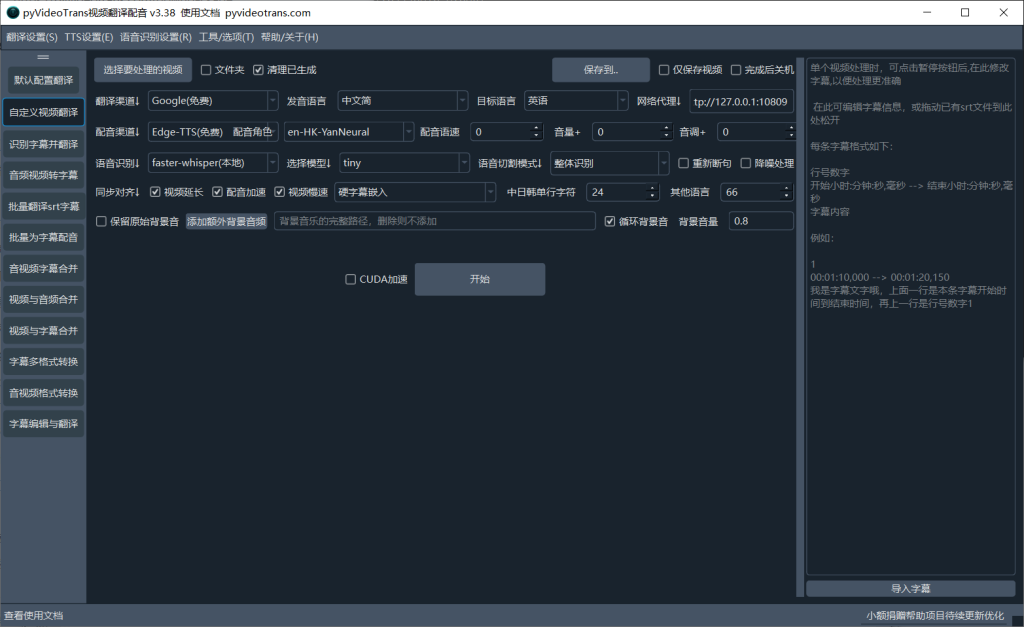

插件使用很简单,主要是有的apikey获取、豆包ai模型参数的入口可能不是那么明确,需要提一下。

1、deepseek apikey获取

先前暂时打不开,最近可以访问创建apikey了,但不太稳定,建议多访问试试。

deepseek支持的模型:

- V3

- R1

2、豆包ai模型 apikey获取

- 到官网火山引擎 https://console.volcengine.com/

- 进入火山方舟 https://console.volcengine.com/ark

- 在左下角有一个API Key 管理管理,里面去创建api key

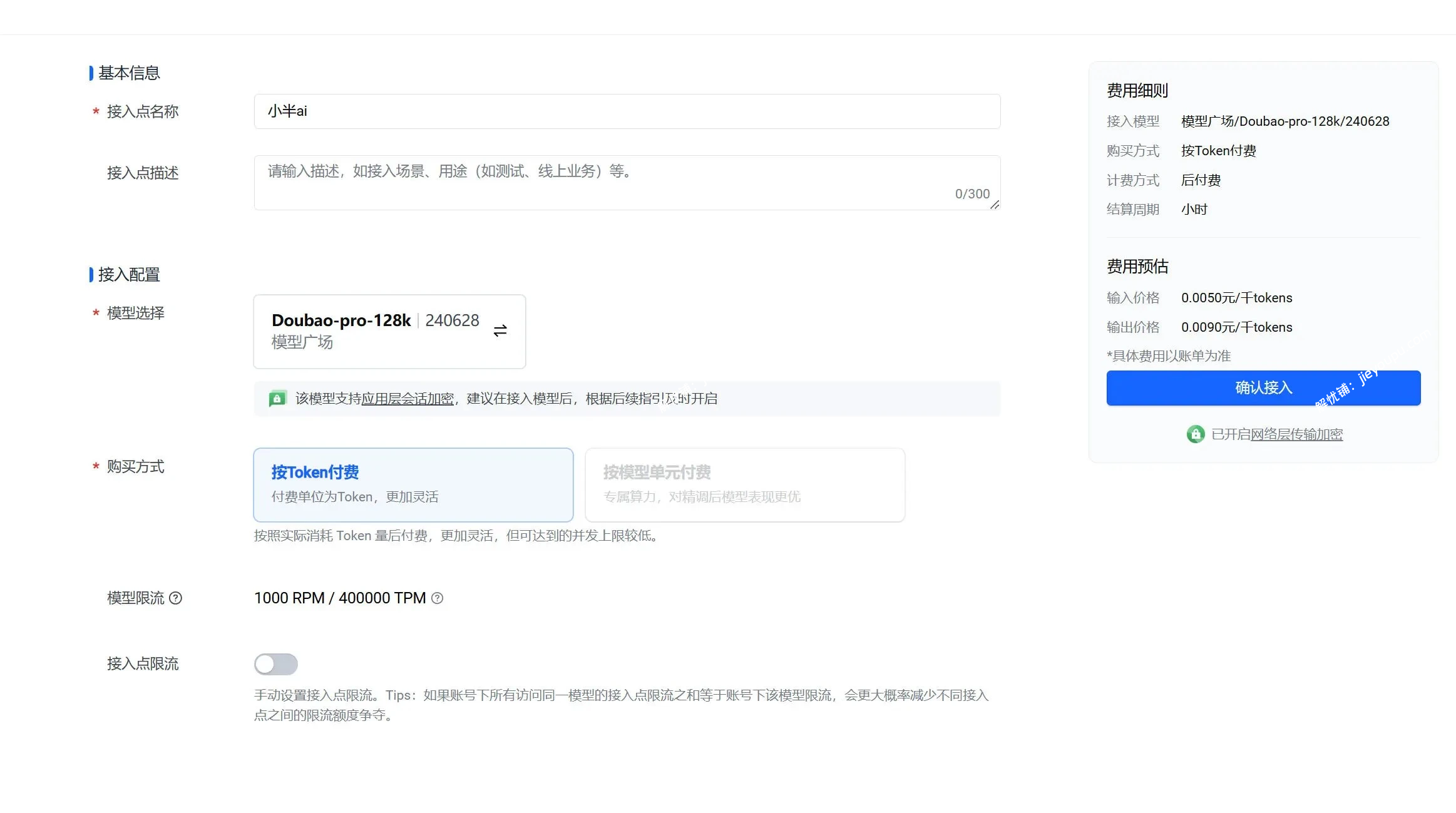

2.1、豆包ai模型 参数获取

- 在火山方舟的菜单找到“在线推理”菜单入口

- 点击进去创建推理接入点

- 创建之后,有一个接入点名称,然后下面有一个ep开头的参数,把这个复制粘贴到插件设置里面

豆包ai模型创建推理接入点的时候,在里面选择自己的模型,如果模型你之前没有开通,需要按提示先去开通模型。

注:如果只是免费测试,我不太推荐豆包ai,因为我自己就开发测试,给自己搞欠费了,免费额度太少了。

豆包ai支持的模型:

- 纯文本类型,语言类的

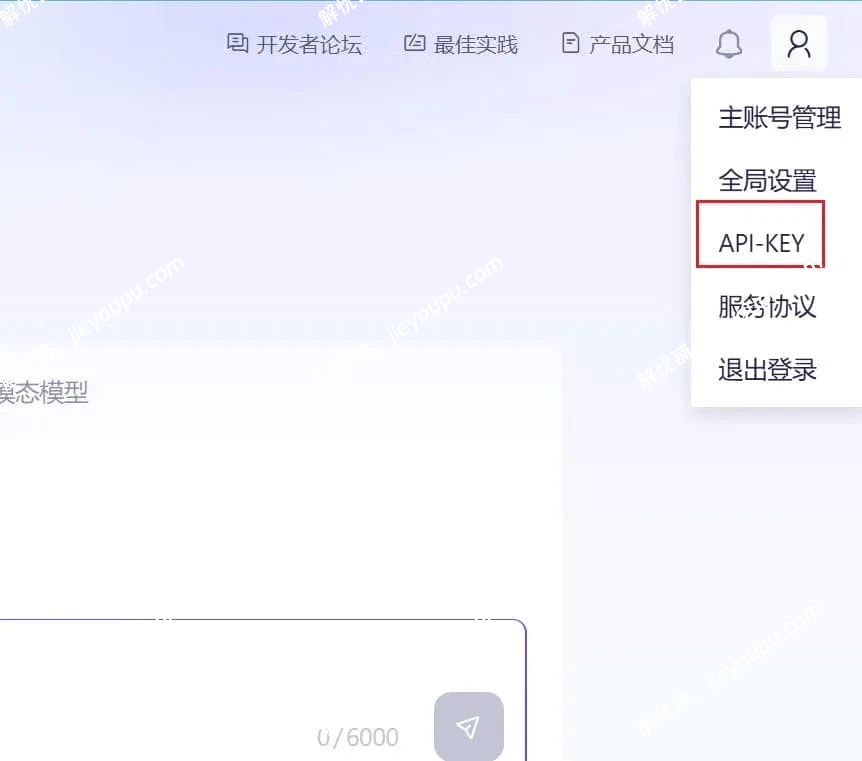

3、通义千问apikey获取

- 进入阿里云官网进入阿里百炼页面 https://bailian.console.aliyun.com

- 在网页右上角头像图标这里 可以看见一个 api-key

- 点击进去创建apikey

通义千问支持的模型:

- qwen-max

- qwen-plus

- qwen-turbo

- qwen-long

- qwen-mt-plus(翻译)

- qwen-mt-turbo(翻译)

- qwen2.5-14b-instruct-1m

- qwen2.5-1.5b-instruct(官方暂时完全免费)

- wanx2.1-t2i-turbo图片生成

- wanx2.1-t2i-plus图片生成

如果要用通义千问生成文章,请选择qwen-long模型。

4、关于文章总结

如果ai的接口太慢了,会导致文章加载很慢。

原文链接:https://www.jieyoupu.com/215.html,转载请注明出处。

1.本站提供的资源,均来自网络,版权争议与本站无关,所有源码仅限用于学习和研究目的。

2.不得将上述内容用于商业或者非法用途,否则,一切后果请用户自负,我们不保证内容的正确性和可行性, 通过使用本站内容随之而来的风险与本站无关,您必须在下载后的24个小时之内,从您的电脑中彻底删除上述内容。

3.如果您喜欢该程序,请支持正版,购买注册,得到更好的正版服务。

4.本站独家正版资源,非授权不得转载出售,个人学习交流请注明转载出处,否则一律追究法律责任。

5.如果网站上有侵权内容,请和我取得联系,我将在24小时内处理,邮箱:twm520@163.com。

评论0